应用层大流量数据攻防清洗浅谈

11月3日,以“深度解读应用及业务安全”为主题的OWASP 2012中国峰会在深圳博林诺富特酒店召开。本届大会从多方面、多角度诠释基于因特网、无线电话网和物联网的应用、融合及业务方面的安全,并围绕应用及业务安全发展方向和威胁增长趋势等方面,进行深层次的探讨。

以下是安全宝产品总监李诚《应用层大流量数据攻防清洗浅谈》的演讲:

安全宝产品总监李诚

大家好,我是李诚,我今天分享的议题是“应用层大流量数据攻防清洗浅谈” 。

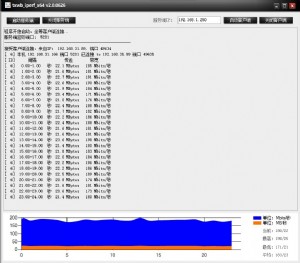

大家可以看到这里有一组对比的数据,这是绿盟2012年上半年安全威胁报告,其中SYN flood占所有DDOS攻击的26.17%,HTTP GET占24.3%,主要是它难于防范导致上升的趋势,今天主要讲解如何解决这个问题。

传统的一些解决HTTP的安全方法,大概是四个方面,最主要的是人机识别。在这个基础之上,现在另外一种结果方式是通过浏览器的跳转,对用户的反应行为进行判断,有很多国内厂商都是这么做的。第三个就是基于问答形式的方式,在Google这边去搜索一个认可,弹出一个验证码,你输入对了之后才有这个访问权利。最粗浅的一层应该是平面的控制,这个代表非常多。他主要的工作的原理就是对统计方面的原理进行控制,查到每个来源访问频率超过我所控制的频率之后就会拉黑一段时间或者是永远的拉黑,这是传统做法的共识。

刚才说到的分析频率计算,这个时候怎么判定有问题还是没有问题?这个时候需要一些阈值,一个IP一秒钟访问30次的请求到底哪个算攻击?这个时候比较靠谱的一点说法就是拿出阈值进行分析,根据“二八原则”去进行分析。觉得哪个合适的话可以配成关键的阈值,然后防御手段被攻击者所熟知,如果碰到IP数的限制,解决方法是我可以多弄一点IP。还有一些特定页面的保护,他可以对某一个URL进行控制,这个达到一定频率的时候会等待或者是返回一个状态,现在我们会碰到这个情况,攻击者往往在攻击的时候会随机生成一个页面,用户网站在收到这些请求的时候,也就是没有这个页面的话他会返回404,如果有一个页面的话正常去响应,这样的话达到了消耗用户网站这样一个目的。现在回到主题安全的行为分析,怎么做分析?我们通过数据找到一些问题,找到问题之后进行妥善的处理,这是我们大的思想,然后分析什么,这里怎么分析就有差异了,然后就是把所有的数据进行统计,然后把一个一个事件关联起来,对于异常的个体怎么定义它?可能有些像重复的行为还有周期频率,重复就是某一个来源的IP,不断地做某些事情,重复地返回3、4个页面这就是重复的周期过程。然后周期的频率就是两个请求或者是请求之间的间隔是大致固定的这么一个过程。还有个体特征,比如在携带了WWW.BAIDU.COM,单独从日志上看从百度错误的页面蹦到淘宝上了。当时我们根据分析所有的数据之后我们得知出来,那个其实是属于攻击特征的一种。然后一些传统的日志,主要是监控变化趋势。传统的DDOS攻击的时候我们会有各个层面去监控这些东西。比如说流量的突然上涨,比如说网站的负载增高、延长的增加这些都是可以监控起来的变化趋势。最重要的我们通过所有的数据当中拿到一般的抽象化的模型,通过这个模型指导后面一系列的分析。

下面一个原始数据流是指用户的流量,通过分工提取拿到的数据进入到收集层,这时候会归整、记录,这些分析过的数据在数据管理保持一些好的策略,在这些数据关联分析再通过人为干预之后会有一些决策,这些干预到整个过程,这是一个大概的逻辑图。

这里有两个地方提一下,一个是实时数据分析,它的优缺点列了一下,这里的数据量有限的,因为这块实时数据分析这样对计算的性能各方面要求很高,不能进行相对复杂的计算,而且访问的逻辑饱和在里面,当然它非常明显就是实时性非常高。然后离线数据分析就是从日志里面拿得数据,整个实时性降低一些,他的优点更复杂的计算,更大的数据量,逻辑上也能从整个用户的逻辑中得出来。均衡就是准实时数据方案,最后希望达到折中的方案,这样我们不需要进行中等复杂的计算结果,达到事先证明的效果。从攻击过来,我们首先怎么预计攻击?怎么去预知攻击?感知攻击行为大概可以从几个方面入手,一个是流量的变化,流量的变化是指某一个网页的访问量突增,或者是说某一个访问量有突增加,然后还有全局的访问量的突增。复杂的话就是CPU的消耗程度,还有它的响应时长,还有一些异常变化,比如说错误率,正常的网站提供错误率的时候可能是一个正常的状态比如说1%或者是2%,但是突然异常的错误率上升到一个标准的时候,这也是我们考量的标准,然后从这里看到独立的信息。关联分析主要是从事两个方面的关联,第一个是提取一般化的模型,还有一个提取恶意特征。抽取这个模型之后找不同,最终会得出一个结果跟哪个更相似一点,更相似有可能是正常的有可能是恶意的,这是通过匹配找出他们的不同。这里特别要提出一个观点,我们怎么判断攻击?需要通过风险评估来处理。

风险评估两方面:一个是网站的可用性评估,他是不是引起网站资源的持续恶化;然后恶意性评估,他这个不是具备攻击性,然后是不是有恶意的?进行评估,评估之后产生一个结果,进一步的降低我们的认证,判断我们的准确性,搜集数据再进行数据分析,再确认,通过策略确认的时候下达一个有效的策略。在某些特定的情况之下我们还有一个排列组合的思想,当请求到达一个地方的时候实际上按照时间轴来排列的,我们其实并不知道哪个是正当请求、哪个是恶意请求。重新进行排列,我们保证正常用户有响应的机会,而那些恶意用户比较高的这样就会往后排,这样的话我们尽量地满足正常用户更多的需求。

其实目标的话,通过数据按照分析做一层应用安全防护体系,这里两个词需要强调,一个是“聪明”一个是“体系”,上午的议题很多人讲WAF的概念,现在绝大多数的做法是向政府匹配,通过这些方式寻找恶意请求,我们通过这些特征判定,但是实际上通过我们数据分析做一些体系的话,某一个页面的参数,其他的可能是一个数字类型的,那么在里面出现一些奇怪的语法的时候,通过数据分析做判定的时候,如果是一个请求过来URL里面出现的奇怪的语法,或者是做一些非正常的行为的时候,这时候可以类似白名单的方式去防范。感谢大家。

天下网吧·网吧天下

天下网吧·网吧天下