云计算:我不是泡沫

本刊记者 孙泠

从“网络就是计算机”到“网格计算”,从“分布式计算”到“互联网计算”,长期以来,与“云计算”相类似的理念被学术界和不同的企业各自表述——虽然各个理念的内涵有些细微的差别,但大多基于充分利用网络化计算与存储资源、达成高效率低成本计算目标的考虑,希望能更好地整合互联网和不同设备上的信息和应用,实现最大范围的协作与资源分享。

杀手应用

“云计算”理论和尝试已经有10多年。近10年来,从.NET架构到“按需计算”(On-demand)、“效能计算(Utility Computing)”、“软件即服务”(Software as a service)、“平台即服务”(Platform as a service)等新理念、新模式,其实都可看作企业对“云计算”的各异解读或“云计算”发展的不同阶段。

亚马逊(Amazon)所推出的S3(Simple Storage Service)和EC2(Elastic Compute Cloud)标志着“云计算”发展的新阶段:基础架构的网络服务作为提供给客户的新“商品化”的资源,而今,EC2已成为亚马逊“增长最快的业务”。IBM则于2007年推出了“蓝云”(Blue Cloud)计算平台,帮助客户进行云计算环境的搭建。此外,Google一直在积极推广其App Engine;而Salesforce.com推出的CRM平台作为服务也产生了很大的影响;2008年,微软终于发布其云计算平台Windows Azure,并在全球范围建造数据中心。

以企业级应用为代表的私有云的大规模应用,标志着云计算从概念到商用普及的真正落地。人们在云计算的诞生之初担心:如果仅仅徘徊在共有云,云计算将重蹈十年前网格计算(Grid computing)的覆辙——停留在公益与研究领域,始终不能迈过大规模商用的门槛。

如今回头去看,十年前Sun、甲骨文、IBM等大公司热衷网格的用意十分明显:销售自己的软件、服务器、数据库产品,甚至整体解决方案。

这里面欠缺了什么?

看到云计算的演变,人们恍然大悟:网格所欠缺的,恰恰是最为重要的杀手级应用。

现在的状况和十年前相比有很大区别,目前对海量数据进行分析和处理的应用在很大程度上增加了人们对计算力的需求。在意识到从巨型机向商用机群转变的好处的同时,人们也发现对这些机群进行管理和操作需要昂贵的成本,并拥有低成本的虚拟化实现技术。最重要的是:亚马逊、Google和微软等公司已经花费了数亿美元用于构建包含成千上万台机器的商用私有云。

“云计算”能够避免泡沫结局,真正走向商业创新,主要归功于三个因素。

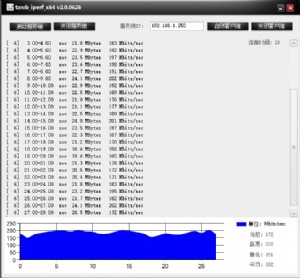

首先是计算、存储、通讯技术的快速发展:CPU多核进化及虚拟化技术的日趋完善,为信息系统的高性能和低功耗找到了重要的突破点;更大的互联网带宽则使得更多的计算资源和软件可以以服务的形式推送到客户端;海量存储、数据挖掘、人工智能等技术的不断发展也令数据更加结构化、更具语义关联,从而实现了从“数据”到“信息”再到“知识”的积淀和进化,并逐渐发展为互联网服务的“大脑”(Intelligence Inside)。正因如此,原本看似不可企及的梦想因为技术的成熟而成真。

其次,Web 2.0时代,各种非结构化数据被以各种终端上传到互联网,并想要在任何时间、任何地点管理这些数据和应用,只有通过“云”来实现。

第三,服务将成为软件产业的趋势。微软中国研发集团主席张亚勤曾提出一个充满想象力的公式:云计算=(数据+软件+平台+基础设施)×服务。

这个公式表明,“云计算”的终极价值取决于“服务”值的大小,当“服务”值为零时,一切均化为乌有,只有增大“服务”值,才能创造括号里各个项目的最大价值。而在应用的基础上,多大的服务带来多大的成效,没有服务就没有成效。

现在看来,这个趋势无疑更加明显。软件不再只是预装好的“商品”,还可以通过在线服务、随需租用或附带广告的免费版本等多种多样的形式来获取。再如,很多新的功能包括视频点播、信息搜索、在线地图,都是传统软件不易实现的功能,所以必须依赖“云层”之上的、规模庞大的计算和数据资源。

天下网吧·网吧天下

天下网吧·网吧天下