《纽约时报》深度剖析谷歌大脑简史

Le并没有觉得“猫脸识别”的成果让他变得更有发言权,但是,他感受到了一种动力,这种研究也许跟他早年希望开发的聊天机器人有联系。在“识别猫”的论文发表以后,他意识到,如果你能让一个神经网络对照片进行总结,你也可以让它对一些句子进行总结。在接下来的两年中,这些想法一直缠绕着Le,以及他在谷歌大脑的同事——Thomas Mikolov。

有一段时间,他们与谷歌的高管分享同一个办公室。后来有一天他们从管理员处得到一封电子邮件,要求他们不要再让团队成员在Larry Page和Sergey Brin的套房前面的沙发上睡觉。后来,他们终于在街道对面分到了一个办公室。

在谈到Mikolov时,Le变得很严肃,但是又不断提起他们的合作。后来才知道,原来Mikolov后来去了Facebook。

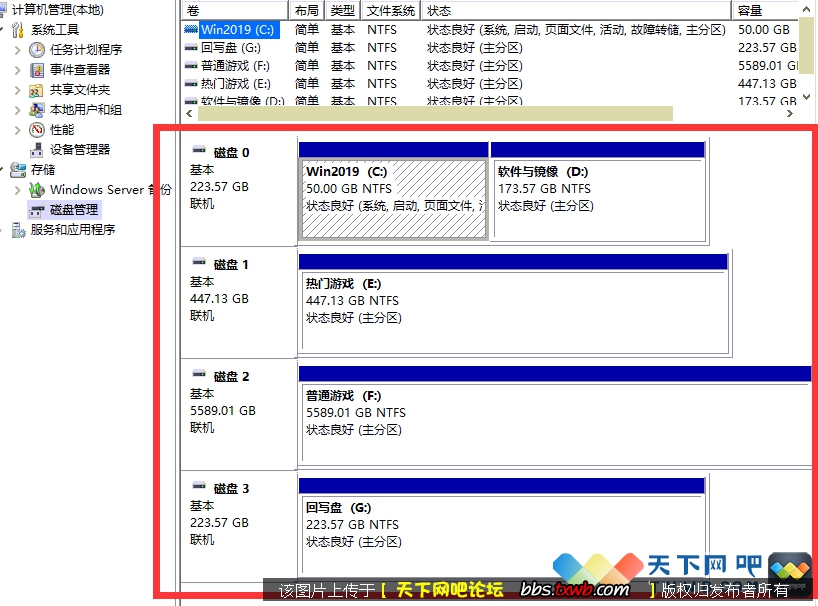

Google Brain团队成员2012年合影,他们著名的“计算机识别猫脸”展示了神经网络分析未标记数据的能力。来源:谷歌

他们在这段时间试图设计出的神经网络架构,不仅可以适应简单的照片分类,这是静态的,而且还复杂的结构,随着时间的推移变化的,如语言或音乐。这些概念许多是在20世纪90年代首次提出的。Le和他的同事回到了那些长期被忽视的概念中,看看他们可以收集什么。他们知道,一旦你建立了一个具有基本语言预测能力的设施,你就可以继续做其他各种智能的事情,例如预测一个合适的电子邮件回复,或预测一个智能的谈话的流程。你就可以侧重于那种看起来很像思维的能力,至少从表面看是这样的。

第二部分:语言机器

5.语言学的转折

谷歌大脑中现在有上百名的成员,但是它看起来并不像是一个有着明显的层级结构的部分,而是更像一个俱乐部或者学术团体,或者一个小酒吧。团队成员不少是来自谷歌整个体系中最自由、最受敬仰的员工。他们现在在一个两层蛋壳建筑中办公,有巨大的窗户:他们的小厨房有一个桌式足球我从来没有见过使用;Rock Band我从来没有见过使用;和一个Go工具箱我看到使用了几次。

我在6月份第一次到谷歌大脑办公室时,还有许多空余的办公位,但是现在已经全满了。

谷歌大脑的成长使得Jeff Dean对公司如何处理需求感到有些担忧。他希望避免在谷歌被称为“成功灾难”——这种情况指的是,公司的理论研究能力超过了实际开发产品的能力。某一天,他在做了一些计算后,向高管作了汇报,只用了两页的PPT。

“如果未来每个人每天都对自己的安卓手机说话三分钟,”他告诉高管,“(由此产生的数据计算需求)就是我们所需要的机器数量。”未来,他们需要把自己的全球计算配置翻2-3倍。

“这也就是说,你必须建造新的大楼,”Jeff Dean在说这话时,带了明显的犹豫和斟酌。

但是,他们显然还有另一个选择——设计出大规模生产的,能在不同的数据中心分散使用的新芯片。加快运算速度。这些芯片被称为TPU。这些芯片比传统芯片在精确度上要低一些。但是运算速度更快。从12.246X64.392变为12X54。

在数学层面上,神经网络只是数百或数千或数万的矩阵乘法,以连续不断的形式出现。所以,让计算更快比更准确要重要。

通常,”Dean说,“专用硬件是个坏创意。它通常只可以加速一件事。但是由于神经网络的通用性,你可以利用这个专用硬件来处理很多其他事情。“

就在芯片设计接近完工时,Le和他的两位同事终于证明了神经网络可能可以处理语言结构。他描绘了一个”词嵌入”的概念,这一概念出现已经有10年了。也就是说,当你对图像进行总结时,你可以分隔图像,来分阶段组成总结,比如边缘、圆圈等等。当你用相同的方式对语言进行总结,你最重要的是要制造出关于距离的多维度地图。机器不会像人类一样去“分析”数据,使用语言规则来区分是名词还是动词。它们只是转化和改变或者组合地图中的词。

如果你能把所有法语中的词和所有英语重点词放在一起,至少在理论上,你可以训练一个神经网络,来学习如何把一个句子放到空间中,并产生一个类似的句子。

你要做的是把这些数百万的英语句子作为输入,把可能的法语句子作为输出,在多次训练后,模型能是被出相关的词语组合模型,这和图像识别中的像素模型是一样的。然后你就能给机器一个英语句子,让他它产出一个与之匹配的法语句子。

词和像素最大的不一样在在于,图中的像素是一次性能全部拿到的,但是,词的出现是根据时间渐进的。你需要让网络“记住”这种连续性,或者序列性。2014年9月,有三篇论文发表,一篇是Le写的,另外两篇来自加拿大和德国,这些论文至少提供了完成这些任务所需要的理论工具。这些研究让谷歌大脑中的一些项目成为了可能,比如研究机器如何生成艺术作品和音乐的Magenta。研究也为机器翻译等实用性应用打下了基础。Hinton对《纽约时报》的记者说,他本来认为这些研究要至少5年或者更多的时间才能做成。

6.伏击

Le的论文显示神经翻译是可行的,但他只使用了一个相对较小的公共数据集。(所谓的小只是相对于Google的体量而言。这个数据集实际上是世界上最大的公共数据集。十年来,原有的Google Translate已经收集了上百到上千倍的生成数据。)更重要的是,Le的模型对长于约七个字句子的效果不是很好。

谷歌大脑的研究科学家Mike Schuster接手了指挥棒。他知道,如果谷歌没有找到一种方法来扩展这些理论洞见至生产水平,那么别人会。这个项目花了他接下来的两年。“你会认为,”Schuster说,“要翻译东西,你只需得到数据,运行实验,你就完成了,但实际不是这样的。"

Schuster是个紧张、专注、不显老的人,长着一个晒黑的、活塞形的脑袋,窄肩,长迷彩短裤垂至膝盖之下,脚踏绿色Nike Flyknits鞋。他的模样看起来好像早上他刚从莲蕊中醒来,抓起他那小而无边的椭圆眼镜,像松鼠吃橡子般补充了卡路里,并在来办公室的路上完成了一个轻松的沙漠十项全能。在现实中,他告诉我,他骑行了18英里来上班。

Schuster在前西德的重工业区杜伊斯堡长大,研究电气工程,然后前往京都从事早期的神经网络。在20世纪90年代,他用来运行实验的神经网络机像会议室一样庞大;它要花费数百万美元,必须训练几个星期,却只能做一些你现在可以一小时内在电脑桌面能做到的事。他在1997年发表了一片文章,在之后的十五年里几乎无人引用;而今年,这篇论文已被引用了大约150次。他不失幽默,但他经常露出严厉的表情,我认为这种表情体现了他的德国式克制和日本式克制的结合。

Schuster必须处理的问题是缠结性的。首先,Le的代码是定制化的,它与Google当时开发的新开源机器学习平台TensorFlow不兼容。Jeff Dean在2015年秋天向Schuster指派了另外两位工程师,Wu Yonghui和Zhifeng Chen。他们花了两个月的时间把Le的结果复制到新系统。Le也在附近,但即使Le本人也不是总能理解项目的进展。

正如Schuster所说,“有些东西的进展不是能完全意识到的。工程师自己也不知道新系统为什么行得通。

今年二月,谷歌的研究机构——该机构是谷歌的一个较为散漫的部门,大约1000名员工,致力于前瞻性和不可分类的研究——在旧金山威斯汀酒店的联合广场上召集骨干进行外出静思会,酒店的豪华程度略逊于谷歌在一英里外的自家店铺。上午进行了几轮“闪电会谈”,快速交流了研究前沿,下午则在跨部门的“互促性讨论”中度过。谷歌希望静思会可以带来不可预测的、间接的、贝尔实验室式的交流,以让谷歌这个成熟的公司保持多产。

在午餐时间

本文来源:不详 作者:佚名

天下网吧·网吧天下

天下网吧·网吧天下